الهجوم السيبراني على الذكاء الاصطناعي: مخاطر، أنواع وطرق التصدي، الذكاء الاصطناعي (AI) أصبح العمود الفقري للعديد من الصناعات الحديثة، من الرعاية الصحية إلى الأمن القومي، حيث يعتمد عليه في تحليل البيانات، اتخاذ القرارات، وحتى القيادة الذاتية. لكن مع هذا التقدم المتسارع، ظهرت مخاطر جديدة تتمثل في الهجمات السيبرانية التي تستهدف هذه الأنظمة الذكية. الهجوم السيبراني على الذكاء الاصطناعي ليس مجرد اختراق تقني، بل تهديد استراتيجي يمكن أن يعطل حياة الملايين ويهدد الأمن العالمي.

في هذا المقال، سنستعرض ماهية هذه الهجمات، أسباب استهداف الذكاء الاصطناعي، أنواعها، أمثلة واقعية، وكيفية التصدي لها، مع تسليط الضوء على التحديات المستقبلية وحلول مثل “سايبر وان”.

الهجوم السيبراني على الذكاء الاصطناعي

الهجوم السيبراني على الذكاء الاصطناعي يشير إلى أي محاولة متعمدة لاستغلال أو تعطيل أنظمة الذكاء الاصطناعي عن طريق التلاعب بخوارزمياتها، بياناتها، أو مخرجاتها. يهدف المهاجمون إلى تغيير سلوك النظام، سرقة معلوماته، أو إفساد قراراته. على عكس الهجمات التقليدية التي تستهدف البرمجيات أو الأجهزة، تتطلب هذه الهجمات فهمًا عميقًا للتعلم الآلي والنماذج الرياضية التي تدعم الـ AI، مما يجعلها أكثر تعقيدًا وخطورة.

تزايد استخدام الذكاء الاصطناعي في مختلف المجالات مثل الرعاية الصحية، المالية، والصناعات الأخرى، مما يجعله هدفًا جذابًا للمهاجمين. يمكن أن تشمل الهجمات السيبرانية على الذكاء الاصطناعي تقنيات مثل التلاعب بالبيانات أو الهجمات على النماذج المدربة مسبقًا، مما يؤثر على دقة قرارات الأنظمة. لمواجهة هذه التهديدات، من الضروري أن تستثمر المؤسسات في أمان الأنظمة الذكية وتطوير حلول مبتكرة للحفاظ على سلامة البيانات وضمان استقرار الأنظمة.

أهمية الذكاء الاصطناعي وأسباب استهدافه

تتمثل أهمية الذكاء الاصطناعي في قدرته على تحسين الكفاءة واتخاذ القرارات بشكل أسرع وأكثر دقة في مختلف المجالات مثل الرعاية الصحية، التعليم، والصناعة، وتتمثل اسباب استهداف الذكاء الاصطناعي في:

- الاعتماد المتزايد: كلما زاد الاعتماد على الـ AI، زادت قيمته كهدف.

- البيانات الحساسة: يعتمد الذكاء الاصطناعي على كميات هائلة من البيانات التي تجذب المهاجمين.

- التأثير الكبير: إفساد قرارات الـ AI يمكن أن يسبب فوضى واسعة النطاق.

- الثغرات التقنية: النماذج الذكية تحتوي على نقاط ضعف يمكن استغلالها.

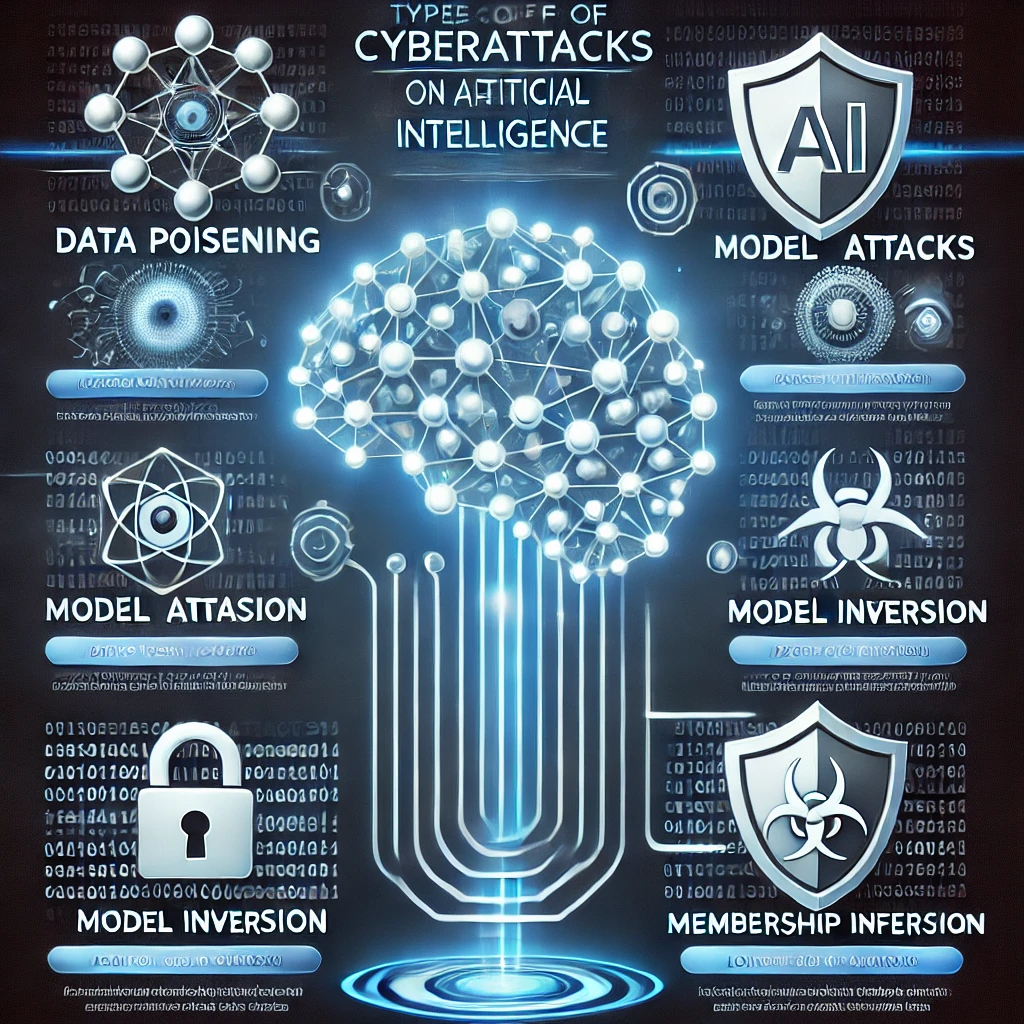

أنواع الهجمات السيبرانية على الذكاء الاصطناعي

أنواع الهجمات السيبرانية على الذكاء الاصطناعي

تتنوع الهجمات السيبرانية التي تستهدف أنظمة الذكاء الاصطناعي وتشمل عدة أنواع تهديدات خطيرة. من أبرز هذه الهجمات:

هجمات البيانات (Data Poisoning)

يتم في هذه الهجمات إدخال بيانات ضارة إلى مجموعة البيانات المستخدمة لتدريب نموذج الذكاء الاصطناعي. هذا يمكن أن يؤدي إلى مخرجات غير دقيقة أو حتى سلوك ضار. على سبيل المثال، إذا تم تدريب نظام أمني على التعرف على الوجوه باستخدام بيانات مُحرفة، فقد يفشل في تحديد المجرمين أو يتعرف عليهم بشكل خاطئ.

هجمات التسميم (Data Poisoning)

يتم فيها إدخال بيانات مزيفة أثناء التدريب لتغيير سلوك النموذج.

هجمات الخصوصية (Privacy Attacks)

تهدف هذه الهجمات إلى استخراج معلومات حساسة من نماذج الذكاء الاصطناعي. على سبيل المثال، يمكن لمهاجم استنتاج البيانات الأصلية المستخدمة في التدريب، مثل الصور أو النصوص.

الهجمات التضادية (Adversarial Attacks)

إضافة تغييرات طفيفة للمدخلات (مثل الصور) لخداع النموذج دون أن يلاحظ الإنسان.

هجمات حرمان الخدمة (Denial of Service Attacks)

تركز هذه الهجمات على إغراق الأنظمة الذكية بكمية هائلة من الطلبات، مما يجعلها غير قادرة على تقديم خدماتها أو اتخاذ قراراتها.

هجمات الخصائص الضارة (Adversarial Attacks)

تشمل إضافة تغييرات صغيرة ولكنها ضارة إلى المدخلات، مثل الصور أو النصوص، لخداع النموذج الذكي. على سبيل المثال، يمكن تغيير صورة إشارة مرور بطريقة تخدع سيارة ذاتية القيادة لتفهم الإشارة بشكل خاطئ.

سرقة النماذج (Model Theft)

وذلك عن طريق استخراج تفاصيل النموذج لإعادة استخدامه أو استغلاله.

هجمات التلاعب بالخوارزميات (Algorithm Manipulation)

يتم في هذه الهجمات استهداف الخوارزميات نفسها، من خلال تعديل عملياتها الداخلية أو التلاعب بالرموز المصدرية.

هجمات العكس (Inversion Attacks)

وتتم من خلال محاولة استعادة البيانات الأصلية من مخرجات النموذج.

أمثلة حقيقية للهجمات السيبرانية على الذكاء الاصطناعي

تتزايد الهجمات السيبرانية على أنظمة الذكاء الاصطناعي في مختلف المجالات، وفيما يلي بعض الأمثلة الحقيقية لهذه الهجمات:

1.هجمات المركبات ذاتية القيادة

استهدف باحثون سيارات ذاتية القيادة بهجمات خصائص ضارة (Adversarial Attacks) من خلال وضع ملصقات على إشارات المرور، مما أدى إلى أخطاء في التعرف على الإشارات.

2.استغلال أنظمة الذكاء الاصطناعي في الأمن السيبراني

في بعض الحالات، تم استهداف أنظمة الحماية التي تعتمد على الذكاء الاصطناعي من خلال بيانات ملوثة لتضليل أنظمة الكشف عن الهجمات.

3.هجمات الذكاء الاصطناعي في التطبيقات الطبية

تم تحريف بيانات صور الأشعة أو التحاليل المخزنة في الأنظمة الطبية لتوفير تشخيصات غير صحيحة، مما قد يؤدي إلى عواقب كارثية.

وفيما يلي اشهر الامثلة الواقعية لهذه الهجمات:

- هجوم على Tesla Autopilot (2019): باحثون استخدموا ملصقات مضادة على إشارات المرور لخداع نظام القيادة الذاتية لتسلا، مما جعله يتجاوز الإشارات.

- تسميم بيانات في الرعاية الصحية (2021): تم اكتشاف محاولات لإدخال بيانات مزيفة في أنظمة AI لتشخيص الأمراض، مما أدى إلى نتائج خاطئة.

- هجوم على ChatGPT (2023): مهاجمون حاولوا استغلال النموذج لتوليد محتوى ضار عبر مدخلات معدلة بعناية.

كيف يتم التصدي للهجمات السيبرانية على الذكاء الاصطناعي؟

التصدي للهجمات السيبرانية على الذكاء الاصطناعي يتطلب تطبيق مجموعة من الاستراتيجيات والتقنيات المتقدمة لضمان أمان الأنظمة وحمايتها من التهديدات. ومن أبرز طرق التصدي:

1. تحسين جودة البيانات

•يجب التأكد من نظافة وصحة البيانات المستخدمة في تدريب النماذج.

•إجراء فحوصات دورية لاكتشاف أي تلاعب محتمل في البيانات.

2. تطوير أنظمة مقاومة للهجمات (Robust Models)

•استخدام خوارزميات قادرة على التعرف على الهجمات الضارة وتجاهلها.

•تدريب النماذج على كشف محاولات الخصائص الضارة.

3. التشفير وحماية الخصوصية

•استخدام تقنيات التشفير لحماية البيانات أثناء نقلها أو تخزينها.

•تطبيق تقنيات مثل التعلّم الفيدرالي (Federated Learning) لتقليل الحاجة لنقل البيانات.

4. اختبارات الأمان المستمرة

•إجراء اختبارات أمان دورية لأنظمة الذكاء الاصطناعي لكشف الثغرات.

•توظيف فرق أمنية متخصصة في أمان الذكاء الاصطناعي.

5. الذكاء الاصطناعي الدفاعي (AI for AI Security)

•استخدام أنظمة ذكاء اصطناعي متقدمة لمراقبة وحماية أنظمة الذكاء الاصطناعي الأخرى.

التحديات المستقبلية في حماية الذكاء الاصطناعي

واجه حماية الذكاء الاصطناعي مجموعة من التحديات المستقبلية التي قد تؤثر على أمان هذه الأنظمة واستدامتها. من أبرز هذه التحديات:

سايبر ون: حلول متقدمة للأمن السيبراني بقيادة المهندس أحمد بطو لحماية الأنظمة الذكية من التهديدات المتطورة

شركة “سايبر ون” هي شركة متخصصة في مجال الأمن السيبراني، تقدم حلولًا مبتكرة ومتقدمة لحماية الأنظمة الرقمية من الهجمات السيبرانية المتطورة. تحت قيادة المهندس أحمد بطو، تركز “سايبر ون” على تطوير استراتيجيات شاملة لتعزيز أمان البيانات وحماية الأنظمة الذكية من التهديدات المتزايدة، بما في ذلك الهجمات على الذكاء الاصطناعي. تقدم الشركة خدمات متميزة في مجالات مثل تحليل المخاطر، حماية الشبكات، والوقاية من البرمجيات الخبيثة، مما يجعلها من الشركات الرائدة في القطاع. بفضل خبرتها الطويلة، تسعى “سايبر ون” إلى توفير بيئة رقمية آمنة للمؤسسات التي تعتمد على التكنولوجيا الحديثة في قطاعات حساسة مثل الرعاية الصحية، المالية، والصناعات التقنية. مع التزامها المستمر بتقديم حلول أمنية متطورة، تظل “سايبر ون” الخيار المثالي للمؤسسات التي تسعى لحماية بياناتها وأنظمتها من الهجمات السيبرانية المتزايدة. “سايبر وان” (CyberOne) تقدم حلولًا متطورة لحماية الذكاء الاصطناعي من الهجمات السيبرانية، مثل:

- تقييم المخاطر: تحليل نقاط الضعف في أنظمة الـ AI.

- حلول مخصصة: تصميم دفاعات ضد التسميم والهجمات التضادية.

- رصد فوري: أنظمة تراقب أداء الـ AI وتبلغ عن أي تغييرات مشبوهة.

- دعم شامل: تدريب الفرق وتوفير استشارات للمنظمات لمواجهة التهديدات.

جميع الحقوق محفوظة لشركة سايبر وان المختصة في الامن السيبراني والجرائم الإلكترونية لا يحق لكم نقل او اقتباس اي شيء بدون موافقه الشركة قد يعاقب عليها القانون.

للتواصل info@cyberone.co

00972533392585